Es gibt Werkzeuge, die benutzt man. Und es gibt Werkzeuge, die werden Teil von einem.

LucisArt ist für mich das zweite. Genauer gesagt: LucisArt 2.0 mit seinem Wyeth-Setting. Ein Plugin, das seit fast zwanzig Jahren nicht mehr verkauft wird, von einer Firma, die längst nicht mehr existiert, für eine Photoshop-Version, die offiziell Vergangenheit ist.

Und trotzdem – trotzdem – geht jedes einzelne meiner Bilder durch diesen Filter. Jedes. Ohne Ausnahme.

Nicht weil ich nostalgisch bin. Nicht weil ich Angst vor Neuem hätte. Sondern weil nichts, was ich in zwanzig Jahren ausprobiert habe, das gleiche Ergebnis liefert. Nichts.

Was war LucisArt überhaupt?

Für alle, die den Namen noch nie gehört haben: LucisArt war ein Photoshop-Plugin, das in den frühen 2000er Jahren entwickelt wurde. Die Technologie dahinter hieß Differential Hysteresis Processing – ein Begriff, der klingt, als hätte ihn jemand erfunden, um auf Konferenzen klug zu wirken.

Aber hinter dem komplizierten Namen steckte etwas Einfaches: Der Filter konnte lokale Kontraste verstärken, ohne dabei die üblichen Probleme zu verursachen.

Wenn du heute in Lightroom den Clarity-Regler hochziehst, bekommst du mehr Kontrast in den Mitteltönen. Das sieht erstmal knackiger aus, aber bei höheren Werten wird es schnell matschig, haloartig, künstlich. Die Kanten bekommen diese hässlichen hellen Säume, Hauttöne werden fleckig, und das ganze Bild sieht aus wie ein HDR-Unfall.

LucisArt hat das nicht gemacht. Es hat Details hervorgeholt – echte Details, nicht künstliche Kanten – und dabei die Integrität des Bildes bewahrt. Die Farben blieben sauber. Die Übergänge blieben natürlich. Und das Ergebnis sah nicht bearbeitet aus, sondern einfach besser. Präsenter. Lebendiger.

Als würde man eine Brille aufsetzen und plötzlich schärfer sehen – ohne dass die Welt anders aussieht.

Die Version 2.0: Der Sweet Spot

LucisArt gab es in verschiedenen Versionen. Die späteren hatten mehr Funktionen, mehr Regler, mehr Möglichkeiten. Aber Version 2.0 war der Sweet Spot.

Nicht zu kompliziert, nicht zu simpel. Eine Handvoll Presets, die alle einen eigenen Charakter hatten. Und eine Benutzeroberfläche, die so aussah, als hätte sie jemand in einer Nacht zusammengebaut – was sie wahrscheinlich auch hatte.

Aber das Entscheidende waren nicht die Regler. Das Entscheidende waren die Presets. Und eines davon hat mein Leben verändert.

Wyeth: Der Filter, der nach einem Maler benannt wurde

Andrew Wyeth. Falls du den Namen nicht kennst: Er war einer der bedeutendsten amerikanischen Maler des 20. Jahrhunderts. Bekannt für hyperrealistische Bilder, die trotzdem traumhaft wirkten. Für Landschaften, die so detailliert waren, dass man jeden Grashalm sehen konnte, aber gleichzeitig eine Melancholie ausstrahlten, die einem den Atem nahm.

Sein berühmtestes Bild, „Christina’s World“, zeigt eine Frau in einem Feld, die zu einem Haus in der Ferne kriecht. Man sieht jede Struktur im Gras, jede Falte im Kleid, jede Unebenheit im Boden. Aber es ist nicht einfach nur detailliert. Es ist lebendig. Es atmet.

Und genau das macht das Wyeth-Setting in LucisArt.

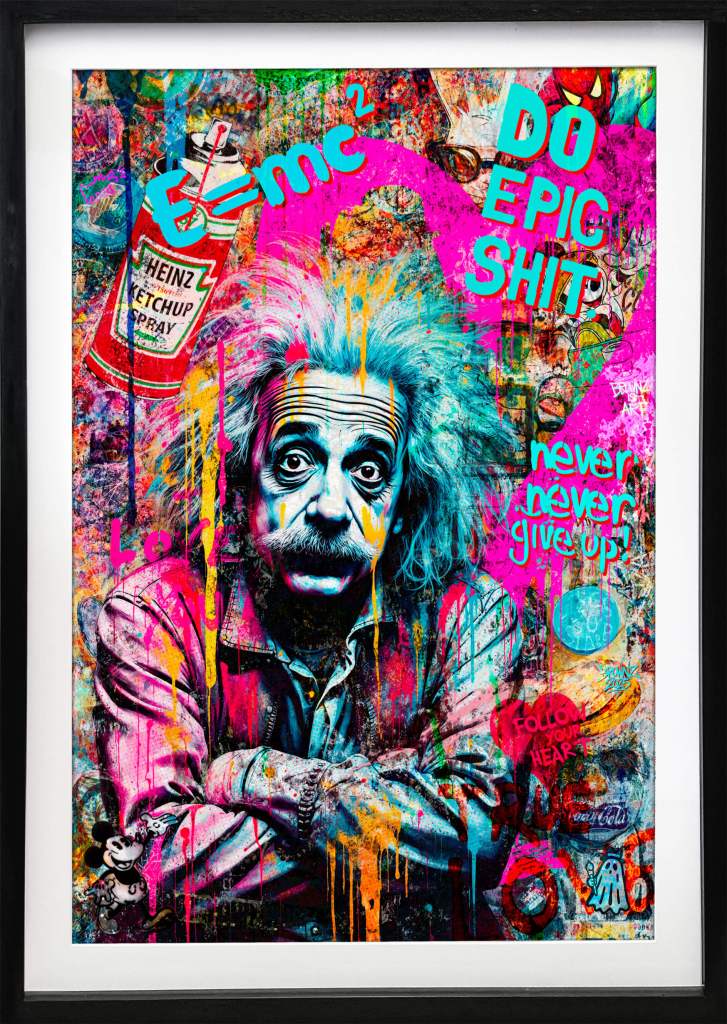

Wenn ich ein Bild durch diesen Filter jage, passiert etwas Magisches. Die Details treten hervor, aber nicht auf eine aggressive Art. Es ist eher, als würde das Bild aufwachen. Als würde es tiefer atmen. Texturen werden greifbar – Haut, Stoff, Holz, Stein – ohne dass sie überschärft oder künstlich wirken.

Der Effekt ist subtil genug, dass die meisten Leute nicht sagen können, was genau anders ist. Sie sagen nur: Das Bild hat etwas. Es zieht mich rein. Es fühlt sich echt an.

Das ist Wyeth. Das ist der Grund, warum ich diesen Filter liebe.

Warum ich dafür Photoshop CS3 benutze

Jetzt kommt der Teil, der manche Leute verwirrt. Ich habe Photoshop 2025. Ich habe Lightroom. Ich habe Capture One. Ich habe Affinity Photo. Ich habe alles, was modern und aktuell ist.

Aber für den finalen Schritt – für das Finish – starte ich Photoshop CS3.

Warum? Weil LucisArt 2.0 nur dort noch läuft und ich ne Installationsversion habe die auf WIN11 funktioniert.

Das Plugin ist 32-bit. Es wurde für Windows XP entwickelt. Es kennt keine 64-bit-Architektur, keine modernen Farbräume, keine GPU-Beschleunigung. Es ist ein Dinosaurier.

Aber dieser Dinosaurier macht etwas, das kein modernes Tool kann.

Also habe ich einen Workflow entwickelt. Ich bearbeite meine Bilder in der aktuellen Software – Farbkorrektur, Retusche, Composing, alles Moderne. Dann exportiere ich eine TIFF-Datei, öffne sie in CS3, lasse LucisArt mit dem Wyeth-Setting drüberlaufen, speichere, und importiere das Ergebnis zurück.

Das sind Extra-Schritte. Das ist umständlich. Das ist altmodisch.

Aber es ist es wert. Jedes einzelne Mal.

Was genau macht Wyeth mit einem Bild?

Lass mich versuchen, den Effekt zu beschreiben – auch wenn Worte hier an ihre Grenzen stoßen.

Stell dir ein Portrait vor. Gute Belichtung, scharfes Objektiv, ordentliche Nachbearbeitung. Es sieht gut aus. Professionell. Sauber.

Jetzt legst du Wyeth drüber.

Die Hauttextur wird sichtbar – nicht die Poren, nicht die Unreinheiten, sondern die Struktur. Die feinen Linien um die Augen, die Textur der Lippen, die Beschaffenheit der Augenbrauen. Alles tritt ein Stück hervor, ohne dass es nach Beauty-Retusche-Rückwärts aussieht.

Die Augen bekommen Tiefe. Die Iris scheint fast dreidimensional zu werden. Die Lichtreflexe werden präsenter.

Die Kleidung – falls im Bild – wird greifbar. Du siehst plötzlich, ob es Baumwolle ist oder Seide. Du siehst die Webstruktur, die Falten, die Art, wie der Stoff fällt.

Und das alles, ohne dass das Bild lauter wird. Ohne Halos. Ohne Artefakte. Ohne diesen typischen Überschärfungs-Look.

Es ist, als würde jemand einen Schleier vom Bild ziehen, von dem du gar nicht wusstest, dass er da war.

Landschaften: Wo Wyeth wirklich singt

So gut das Setting bei Portraits funktioniert – bei Landschaften wird es transzendent.

Gras. Bäume. Felsen. Wasser. Wolken. All diese Dinge, die in der Natur so unglaublich detailliert sind, aber in Fotos oft flach wirken – Wyeth bringt sie zurück.

Ich erinnere mich an ein Bild, das ich vor Jahren gemacht habe. Eine Wiese im Morgenlicht, Tau auf den Grashalmen, ein alter Baum im Hintergrund. Das Foto war okay. Technisch sauber, gut belichtet, ordentlich komponiert.

Dann Wyeth.

Plötzlich sah ich jeden einzelnen Grashalm. Nicht als Linie, sondern als dreidimensionales Objekt. Der Tau glitzerte. Die Rinde des Baumes hatte eine Tiefe, die vorher nicht da war. Das ganze Bild sah aus, als könnte ich hineinsteigen.

Das war der Moment, in dem ich wusste: Diesen Filter gebe ich nie wieder her.

Die Trauer um eine tote Software

LucisArt wurde irgendwann nicht mehr weiterentwickelt. Die Firma – ich glaube, sie hieß Image Content Technology oder so ähnlich – hat aufgehört zu existieren. Die Website verschwand. Der Support endete. Die Downloads wurden eingestellt.

Wer das Plugin nicht hatte, konnte es nicht mehr bekommen. Wer es hatte, konnte es nicht mehr aktualisieren.

Für mich war das wie der Tod eines Freundes. Nicht dramatisch, nicht plötzlich – eher ein langsames Verschwinden. Eines Tages merkst du, dass du die Nummer nicht mehr anrufen kannst.

Ich habe meine Installer-Dateien gehütet wie einen Schatz. Auf mehreren Festplatten gesichert. In die Cloud kopiert. Ausgedruckt – okay, das nicht, aber fast.

Und ich habe versucht, Ersatz zu finden. Jahrelang.

Alles, was ich stattdessen probiert habe

Clarity in Lightroom. Texture in Lightroom. Der High-Pass-Filter in Photoshop. Topaz Detail. Topaz Clarity. Nik Collection Detail Extractor. DxO ClearView. ON1 Detail. Luminar Structure. Capture One Clarity und Structure.

Ich habe sie alle getestet. Manche sind gut. Manche sind sehr gut. Aber keine ist Wyeth.

Es ist wie mit Essen. Du kannst hundert verschiedene Pizzen probieren, und manche sind fantastisch. Aber wenn du einmal diese eine Pizza hattest – in diesem einen Restaurant, an diesem einen Abend, mit dieser einen Kombination aus Teig und Käse und Tomaten – dann weißt du: Das ist der Standard. Alles andere ist nur ähnlich.

Wyeth ist diese Pizza.

Die modernen Tools kommen nah dran. Aber sie haben alle irgendetwas, das nicht stimmt. Entweder sind die Halos zu sichtbar, oder die Farben verschieben sich, oder der Effekt ist zu aggressiv, oder er ist zu subtil, oder er funktioniert nur bei bestimmten Bildern.

Wyeth funktioniert bei allem. Portraits, Landschaften, Architektur, Stillleben, abstrakte Kunst. Es macht alles besser. Immer. Ohne Ausnahme.

Der technische Aspekt: Differential Hysteresis Processing

Ich bin kein Mathematiker, aber ich habe versucht zu verstehen, was LucisArt technisch anders macht. Soweit ich es begreifen kann, geht es um Folgendes:

Normale Schärfungs- und Kontrast-Algorithmen arbeiten mit lokalen Pixeldifferenzen. Sie schauen sich an, wie unterschiedlich benachbarte Pixel sind, und verstärken diese Unterschiede. Das führt zu Kanten – und zu Halos, wenn man übertreibt.

LucisArt arbeitet anders. Es analysiert nicht nur lokale Differenzen, sondern auch, wie sich diese Differenzen über größere Bereiche verhalten. Es erkennt Strukturen statt nur Kanten. Und es verstärkt diese Strukturen, ohne die Kanten künstlich zu betonen.

Das Ergebnis ist eine Art Tiefe, die schwer zu erklären ist. Es ist nicht mehr Kontrast. Es ist nicht mehr Schärfe. Es ist mehr Präsenz.

Und das Wyeth-Preset hat genau die richtige Kalibrierung, um diese Präsenz zu maximieren, ohne sie zu übertreiben. Es ist der Sweet Spot des Sweet Spots.

Warum ich das hier schreibe

Eigentlich schreibe ich das aus Egoismus. Weil ich hoffe, dass irgendwo da draußen jemand sitzt, der LucisArt auch kennt. Der auch noch die alten Installer hat. Der versteht, wovon ich rede.

Weil es einsam sein kann, ein Werkzeug zu lieben, das niemand mehr kennt.

Aber ich schreibe es auch als Warnung. Oder als Mahnung. Oder als was auch immer.

Software verschwindet. Algorithmen sterben. Dinge, die heute unverzichtbar erscheinen, können morgen weg sein. Und wenn sie weg sind, sind sie wirklich weg.

Also: Sichert eure Werkzeuge. Speichert eure Installer. Bewahrt die Dinge auf, die euch wichtig sind. Nicht weil ihr nostalgisch seid, sondern weil manche Dinge unersetzbar sind.

LucisArt 2.0 mit dem Wyeth-Setting ist für mich unersetzbar.

Es ist der letzte Schritt in meinem Workflow. Der Moment, in dem ein Bild aufhört, ein Foto zu sein, und anfängt, ein Bild zu sein. Der Moment, in dem Technik zu Kunst wird.

Eine Liebe auf ewig

Ich weiß, das klingt übertrieben. Ein Filter. Eine Software. Eine Einstellung in einem Dropdown-Menü.

Aber wer kreativ arbeitet, weiß: Werkzeuge sind nicht neutral. Sie formen, wie wir sehen. Sie beeinflussen, was wir machen. Sie werden Teil unserer Handschrift.

Wyeth ist Teil meiner Handschrift.

Jedes Bild, das ich in den letzten fünfzehn Jahren veröffentlicht habe, trägt seinen Fingerabdruck. Diese Tiefe, diese Präsenz, diese Lebendigkeit – das ist nicht nur meine Bearbeitung. Das ist Wyeth.

Und solange Photoshop CS3 auf irgendeinem Computer dieser Welt noch läuft, werde ich diesen Filter benutzen.

Nicht aus Gewohnheit. Nicht aus Sturheit.

Sondern aus Liebe.

Eine Liebe auf ewig.