Kennst du das? Du sitzt auf der Couch, guckst Star Wars, und irgendwann fängt dein Kopf an zu spinnen. Was wäre wenn. Was wäre wenn das ganz anders gelaufen wäre. Was wäre wenn man das Ganze mal komplett durch den Wolf dreht, ohne dass einem jemand reinredet.

Die meisten Leute denken das kurz und dann ist der Moment vorbei. Bier auf, nächste Szene, weiter geht’s.

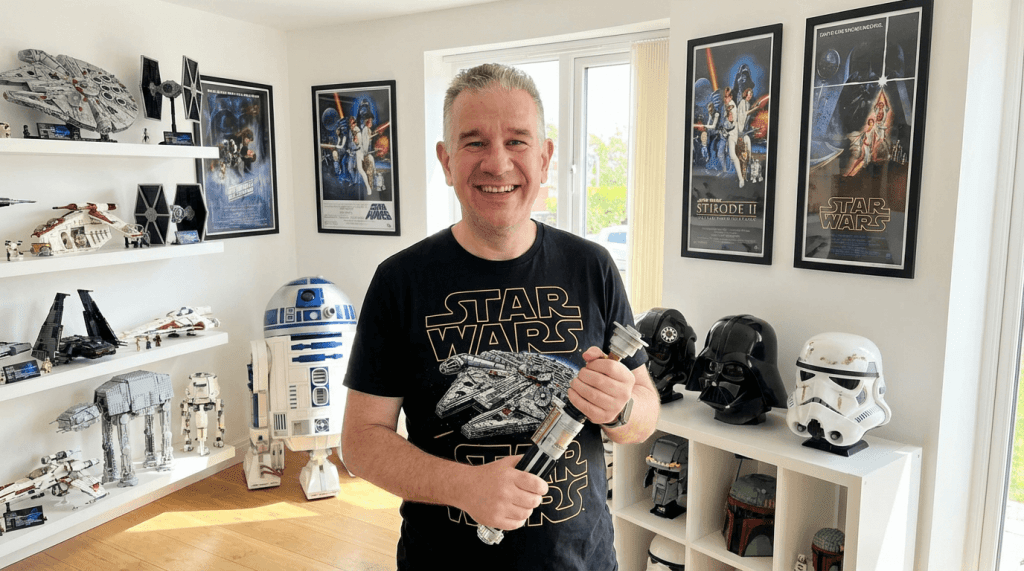

Ich hab es gemacht.

Wie das Ganze entstanden ist

Ich wünschte, ich könnte sagen, da steckt ein großer Plan dahinter. Ein Konzept. Ein Storyboard mit Post-its an der Wand, so wie bei den Profis.

Nee.

Es war eher so: Ich hab mit KI-Videotools rumgespielt, dabei einen Clip generiert, der irgendwie nach Star Wars aussah, und dann dachte ich mir – okay, was passiert wenn ich das weiterspinne?

Und dann hab ich einfach nicht mehr aufgehört.

Clip für Clip. Szene für Szene. Alles zusammengeschnitten in Adobe Premiere. Kein Studio, kein Budget, kein Produzent der nervös auf irgendwelche Tabellen guckt. Nur ich, mein Rechner und diese leicht irre Energie, die man bekommt, wenn ein Projekt anfängt, ein Eigenleben zu entwickeln.

Das Ergebnis ist Star Wars Madness. Und der Name ist Programm.

Hier könnt ihr euch den Wahnsinn anschauen:

Was dich erwartet

Ich versuch mal, das zu beschreiben. Obwohl das schwierig ist, weil ich selbst nicht ganz sicher bin, was da passiert ist.

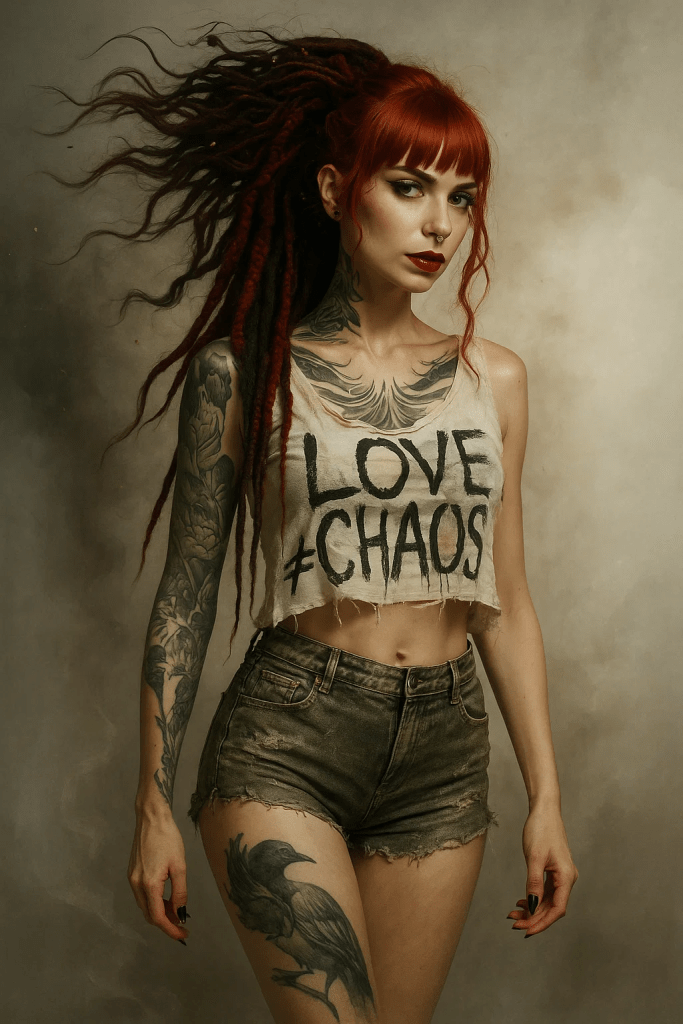

Da sind Raumschlachten drin. Ziemlich viele sogar. Es gibt dramatische Momente, die fast schon episch sind. Und dann gibt es Stellen, die komplett absurd sind. Wo Figuren Dinge tun, die definitiv nicht im offiziellen Kanon stehen. Wo die Logik kurz den Raum verlässt und der Wahnsinn übernimmt.

Es gibt wahrscheinlich zu viele Schnitte. Der Pacing ist stellenweise so aggressiv, dass man kaum Luft holen kann. Und dann wieder Momente, die überraschend ruhig sind.

Es ist chaotisch. Es ist übertrieben. Es ist an manchen Stellen richtig gut und an anderen Stellen denkt man: Was zur Hölle war das gerade?

Aber weißt du was? Genau so fühlt sich Star Wars in meinem Kopf an. Nicht die polierte Disney-Version. Sondern das, was als Kind in mir losging, wenn ich die Filme geguckt hab. Dieses Gefühl, dass alles möglich ist und nichts Sinn machen muss.

Warum Fanprojekte die ehrlichsten Projekte sind

Ich hab damit kein Geld verdient. Ich werd damit kein Geld verdienen. Das war nie der Plan.

Es ging ums Machen. Um dieses Gefühl, wenn du eine Idee hast und sie einfach rauslässt, ohne dass jemand sagt: Das geht nicht, das ist zu teuer, das versteht keiner, dafür gibt es keine Zielgruppe.

Fanprojekte haben diese Freiheit. Du bist niemandem Rechenschaft schuldig. Du musst keine Erwartungen erfüllen. Du musst nur eine Sache: Bock drauf haben.

Und Bock hatte ich. Offensichtlich.

Das Ergebnis ist nicht perfekt. Natürlich nicht. Wie denn auch? Das ist ein Ein-Mann-Projekt, gebaut aus KI-generierten Clips und zusammengeschnitten auf meinem Rechner. Das kann nicht mithalten mit dem, was ILM mit 200 Millionen Dollar macht.

Aber darum geht es auch nicht. Es geht um den Beweis, dass man es kann. Dass die Tools da sind. Dass man als einzelner Mensch, allein in seinem Zimmer, etwas machen kann, das vor zehn Jahren eine ganze Firma gebraucht hätte.

Das finde ich bemerkenswert. Nicht mein Video speziell. Sondern die Tatsache, dass es möglich ist.

Ein Liebesbrief an Star Wars

Star Wars Madness ist kein Ersatz für die echten Filme. Es ist kein Versuch, es besser zu machen. Es ist eher so ein Liebesbrief.

Ein chaotischer, überdrehter, stellenweise komplett durchgeknallter Liebesbrief an das Gefühl, das Star Wars in mir auslöst. An die Freiheit, die eigene Version im Kopf weiterzudenken. An die Erlaubnis, die man sich selbst gibt, einfach mal loszulassen.

Ich weiß nicht, ob das jeder versteht, der es guckt. Vielleicht gucken manche das und denken nur: Was für ein Quatsch. Das ist okay. Ist ja auch Quatsch. Aber es ist Quatsch mit Herz.

Technisch gesehen

Kurzer Nerd-Absatz für die, die es interessiert.

Die Videos sind mit verschiedenen KI-Tools generiert. Den Schnitt hab ich in Adobe Premiere gemacht. Sound, Musik, Effekte – alles zusammengepuzzelt aus verschiedenen Quellen.

Das Ganze war ein Lernprojekt, genauso wie ein Spaßprojekt. Ich wollte sehen, wie weit man mit den aktuellen Video-KI-Tools kommt, wenn man sie wirklich pusht. Die Antwort: Weit. Weiter als ich erwartet hätte. Aber auch mit klaren Grenzen, die man akzeptieren muss.

Wichtig beim Anschauen

Bitte guckt das Ding in mindestens 720p HD. Wirklich. Stellt die Qualität auf YouTube manuell hoch, sonst seht ihr nur Matsch. Der Film lebt von den Bildern und den Details, und wenn YouTube das auf 360p runterkomprimiert, ist der halbe Spaß weg.

Am besten: Großer Bildschirm. Oder zumindest nicht auf dem Handy im Bus. Gebt dem Wahnsinn den Raum, den er verdient.

Nochmal der Link:

https://youtu.be/iTgGyCCMZ4A

Feedback erwünscht

Und dann will ich wissen, was ihr davon haltet.

Ob ihr es liebt, ob ihr es hasst, ob ihr bei einer bestimmten Szene laut gelacht habt oder ob ihr nach zwei Minuten abgeschaltet habt – alles ist willkommen. Schreibt unter das YouTube-Video, schreibt mir hier, schreibt mir eine Mail an brownz@brownz.art – egal wie, Hauptsache ihr sagt was.

Weil allein im stillen Kämmerlein Sachen machen ist schön. Aber zu hören, was andere darin sehen, ist besser.

Also: Einsteigen, anschnallen, mitfliegen.

Und möge die Macht mit euch sein. Oder so ähnlich.

Wie dieser Text entstanden ist

Meine Blogartikel entstehen aus Sprachmemos – meistens wenn ich aufgedreht bin, weil ich gerade was fertig hab und es der Welt zeigen will. Wird transkribiert und mit KI aufgeräumt. Die Fan-Begeisterung und der leichte Wahnsinn sind komplett organisch gewachsen.