🎥 Midjourney Video V1 – Die bewegte Zukunft beginnt jetzt

Datum: 18.–20. Juni 2025

1. Der große Schritt: Video in Midjourney

Am 18. Juni 2025 veröffentlichte Midjourney sein erstes Video‑Generierungsmodell V1, das KI‑animierte Kurzvideos aus Bildern erzeugt youtube.com+9youtube.com+9autogpt.net+9youtube.com+10updates.midjourney.com+10indianexpress.com+10. Fortan kann man direkt im Web oder über Discord ein Bild – selbst ein extern hochgeladenes – animieren, indem man den „Animate“‑Button klickt omni.se+7updates.midjourney.com+7venturebeat.com+7.

Hauptfunktionen:

- Automatisch generierte Bewegungen (Standard‑Motion‑Prompts).

- Manueller Modus: Eigene Bewegungsbeschreibung als Prompt.

- Wählen zwischen low und high motion.

- Erzeugt vier Clips à 5 Sekunden, verlängerbar um maximal 20 Sekunden indianexpress.com+1reddit.com+1midjourneyv6.org+1reddit.com+1reddit.com+9updates.midjourney.com+9theverge.com+9.

- Verfügbar für alle Abo‑Stufen – inklusive Basic‑Plan ab $10/Monat techtimes.com+5theverge.com+5techcrunch.com+5.

- Video‑Jobs kosten etwa 8 × GPU‑Minuten im Vergleich zu Bildern, was pro Sekunde Videos in Reichweite eines Bild‑Upscales bringt reddit.com.

➡️ Ergebnis: „Bezahlbar, experimentell & kreativ“ – so beschrieb Midjourney selbst den Start tomsguide.com+10omni.se+10theverge.com+10.

2. Kontext: Rechtsstreit und Marktposition

Der Launch setzt Midjourney in direkte Konkurrenz zu OpenAI Sora, Runway Gen‑4, Google Veo 3 & Co tomsguide.com+3techcrunch.com+3venturebeat.com+3. Allerdings steht das Unternehmen derzeit auch im Fokus einer Klage von Disney & Universal wegen Urheberrechtsverletzung techcrunch.com+4omni.se+4theverge.com+4. Kritiker befürchten, dass Midjourney seine Trainingsdaten mit urheberrechtlich geschütztem Material gefüttert hat tomsguide.com+15theverge.com+15techcrunch.com+15.

Trotzdem setzt CEO David Holz auf verantwortungsvolles Einsetzen der Technologie und nennt den Video‑Launch einen „Baustein hin zu Echtzeit‑Open‑World‑Simulationen“ reddit.com+6updates.midjourney.com+6theverge.com+6.

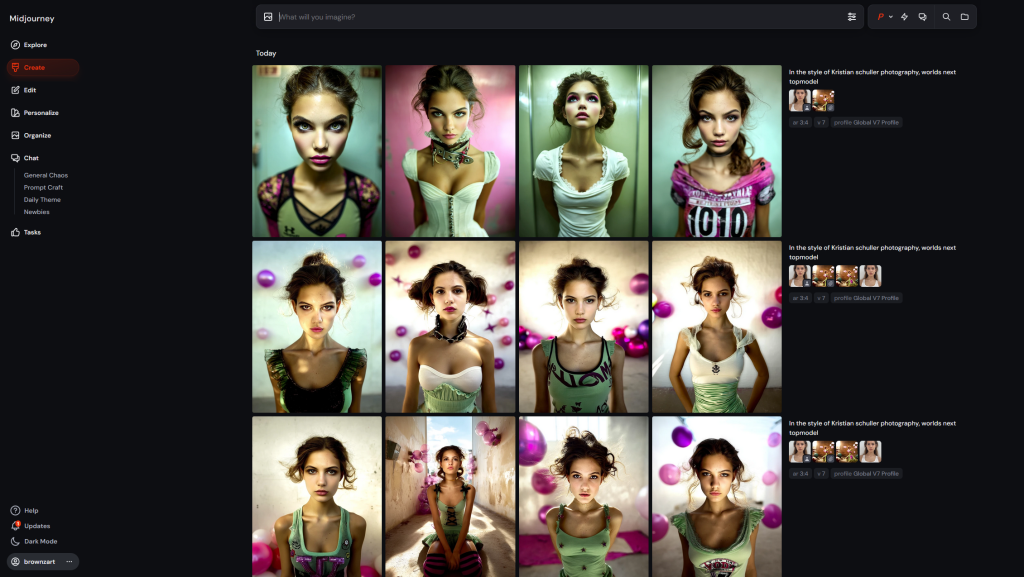

3. V7‑Image‑Model & neue Tools

Zeitgleich wurde V7 zum Standard-Bildmodell erklärt – mit spannenden neuen Features:

Omni‑Reference (--oref)

Ermöglicht konsistente Figuren und Objekte über Szenen hinweg. Per Drag‑&‑Drop ins Prompt‑Bar oder via URL (--oref) midjourneyv6.org+11updates.midjourney.com+11midjourneysref.com+11.

🔧 Best Practices: Bild + aussagekräftiges Text‑Prompt, Gewichtungsparameter --ow zur Feinsteuerung docs.midjourney.com+1midjourneysref.com+1.

Personalization Profiles (--p)

Der Benutzer prägt seinen eigenen Stil: durch vergleichende Bildfragen lernt das System deinen visuellen Geschmack – und setzt ihn um .

Style References (--sref)

Stile wie Studio‑Ghibli oder Brutalismus lassen sich jetzt per Bildreferenz treffgenau wiederholen, mit deutlich höherer Präzision dank V7 medium.com.

Draft Mode (--draft)

Zehnmal schnellere Bildgenerierung bei halben GPU-Kosten. Auf Web durch ⚡️‑Switch oder Prompt‑Param --draft. Sprach‑/Konversationsmodus inklusive .

4. Das Zusammenspiel: Bild trifft Bewegung

Midjourney ermöglicht nun:

- Charakter über

--orefkonfigurieren. - Stil mit

--pund--srefindividuell personalisieren. - Rohkonzept via Draft Mode blitzschnell entwickeln.

- In Video V1 verwandeln: automatische oder manuelle Bewegung hinzufügen, low/high motion wählen, verlängern.

Das ist ein komplett neuer Workflow von statischer Vision hin zur animierten Realität.

5. Chancen & Ausblick

- Für Kreative: Musikvideos, animierte Storyboards, Social‑Media‑Clips uvm.

- Für Künstler: Bewegte Kunst ohne After Effects‑Skills.

- Für die Plattform: wichtige Schritte Richtung Full‑Quest, Real‑Time‑Simulation, 3D‑Modelle angekündigt medium.com+1updates.midjourney.com+1midjourneysref.comupdates.midjourney.com+7techcrunch.com+7autogpt.net+7.

- Risiken: rechtliche Unsicherheiten in Bezug auf Urheber‑ und Trainingsdaten – Klagen von Disney und Universal sind noch im Gange .

6. Fazit – Warum das wichtig ist

Midjourney Video V1 verändert die KI‑Kunstwelt. Es erweitert KI‑Bildgeneratoren endlich in den bewegten Bereich und bricht dabei Barrieren für alle Nutzer: technisch spannend, stilistisch eigenständig, kreativ ungebunden.

Selbstbewusst setzt man auf künstlerische Freiheit, auch angesichts juristischer Herausforderungen, und schickt uns alle auf Liter behind-the-scenes in eine Welt, in der Bilder zu lebendigen Erlebnissen werden.

🔧 Empfehlungen für deinen Workflow

- Starte mit Omni‑Reference (

--oref), um deinen Charakter einzuführen. - Nutze

--p, um deinen Stil zu personalisieren. - Nutze

--draftfür ultra‑schnelle Skizzen. - Wechsle zu Video V1: wähle Automatic für Einfachheit oder Manual für volle Kontrolle.

- Probiere low vs. high motion, und verlängere dein Video – bis zu 20 Sekunden.