Nano‑Banana: Die geheimnisvolle neue Bild-KI mit enormem Potenzial

Einleitung

In der Welt der generativen KI tauchen ständig neue Namen und Modelle auf. Doch nur wenige sorgen so schnell für Aufsehen wie Nano‑Banana – ein Bild-KI-Modell, das aktuell in Testumgebungen kursiert und die Community mit seiner Präzision und Vielseitigkeit überrascht. Trotz fehlender offizieller Ankündigung oder klarer Herkunft sorgt Nano‑Banana für Spekulationen, Begeisterung und große Erwartungen.

1. Herkunft und Entdeckung

Nano‑Banana tauchte erstmals in der LMArena Image Edit Arena auf – einer Art Spielwiese, in der verschiedene KI-Modelle anonym gegeneinander antreten. Schnell stach es durch seine präzisen Umsetzungen komplexer Prompts hervor. Besonders bemerkenswert: Während viele KI-Modelle bei mehrschrittigen Anweisungen ins Straucheln geraten, schien Nano‑Banana gerade darin seine Stärke zu haben.

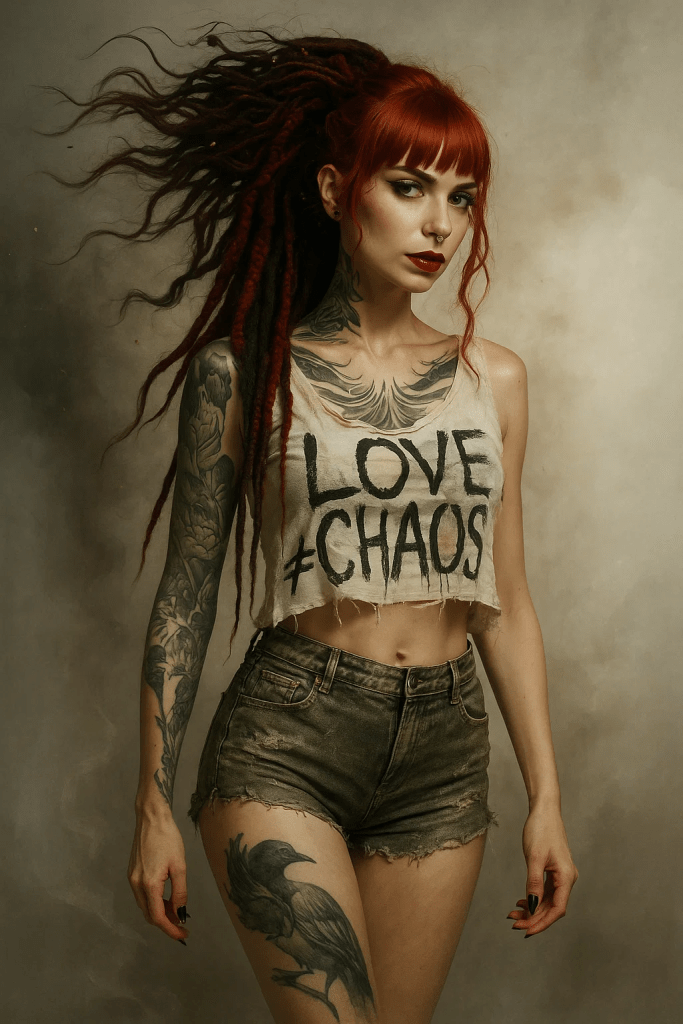

Beispiel: Ein Nutzer forderte die KI auf, im unteren Teil eines Bildes eine Figur in einen Nier: Automata-Charakter und im oberen Bereich eine Figur in Master Chief aus Halo zu verwandeln. Nano‑Banana setzte dies erstaunlich sauber um – was selbst führenden Modellen oft misslingt.

2. Stärken von Nano‑Banana

a) Herausragendes Prompt-Verständnis

Nano‑Banana verarbeitet komplexe Anweisungen sehr präzise. Besonders in Szenen mit mehreren Objekten oder Figuren zeigt es eine Kohärenz, die selten zu finden ist.

b) Konsistenz bei Bildbearbeitung

Während viele Bild-KIs bei nachträglicher Bearbeitung den Stil oder die Lichtstimmung brechen, hält Nano‑Banana erstaunlich gut die visuelle Integrität.

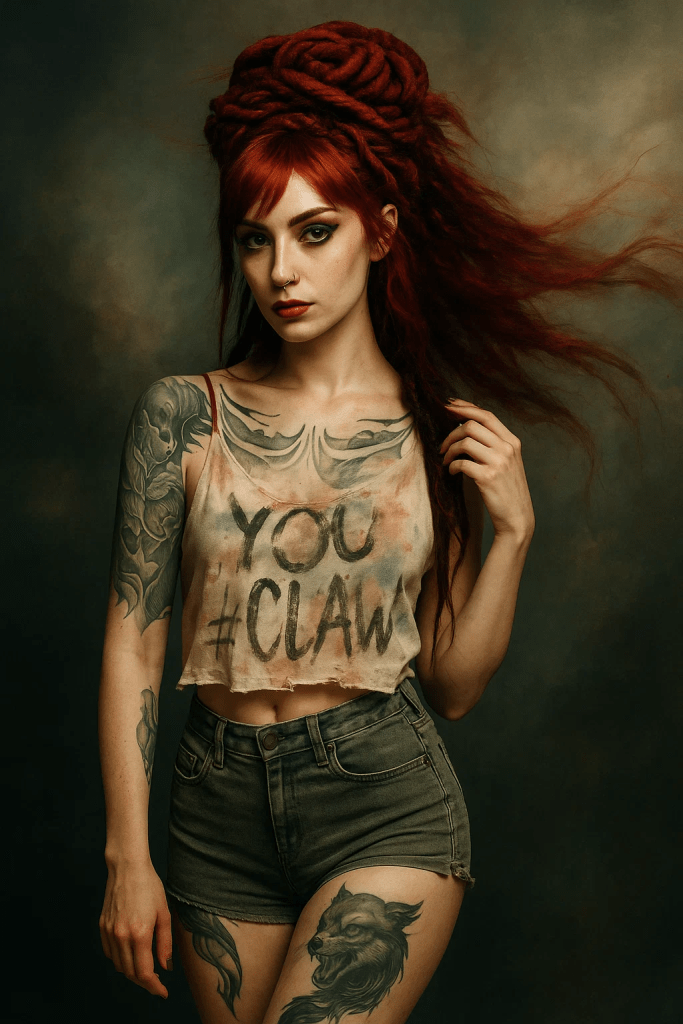

c) Stilvielfalt

Von fotorealistisch bis Anime, von surreal bis klassisch-illustrativ: Nano‑Banana zeigt eine beeindruckende Bandbreite.

d) Geschwindigkeit

In Kombination mit modernen Edit-Frameworks (z. B. Qwen‑Image‑Edit) schafft Nano‑Banana schnelle Ergebnisse in nur wenigen Iterationen.

3. Schwächen und Limitierungen

Natürlich ist auch Nano‑Banana nicht fehlerfrei. Erste Tests zeigen:

- Textdarstellung bleibt ungenau, ähnlich wie bei vielen anderen KI-Modellen.

- Anatomiefehler können auftreten, insbesondere bei Händen oder dynamischen Posen.

- Unklarheit der Herkunft: Ohne offiziellen Release bleibt offen, ob es sich um ein Forschungsprojekt, einen Leak oder ein internes Testmodell handelt.

4. Wer steckt dahinter?

Bislang gibt es keine offizielle Bestätigung. In der Community kursieren verschiedene Hypothesen:

- Google: Manche vermuten, Nano‑Banana könnte ein Abkömmling von Imagen oder ein internes Gemini-Experiment sein.

- Flux AI: Das Unternehmen listet Nano‑Banana bereits in seinem Modell-Portfolio – allerdings ohne volle Freischaltung.

- Indie-Forschung: Andere glauben, es könnte sich um ein unabhängiges Projekt handeln, das noch in der Testphase steckt.

Die Geheimhaltung trägt zweifellos zum Mythos bei.

5. Zugänglichkeit

Aktuell ist Nano‑Banana nur eingeschränkt verfügbar:

- Über LMArena als Testmodell.

- Über Bylo.ai, eine Plattform mit Fokus auf kreative KI-Features (Stiltransfer, Objektaustausch, 2D‑zu‑3D, Porträt-Optimierung).

- Flux AI listet das Modell ebenfalls, hält es aber noch zurück.

Die öffentliche Freischaltung wird mit Spannung erwartet.

6. Vergleich zur Konkurrenz

Nano‑Banana wird häufig mit Imagen 4 verglichen. Fazit der Community:

- Für Text‑zu‑Bild (T2I) bleibt Imagen 4 minimal vorne.

- Für Bildbearbeitung (Image Editing) liefert Nano‑Banana oft die konsistenteren Ergebnisse.

Damit positioniert es sich als Spezialist – weniger ein „Alles-Könner“, mehr ein Präzisionswerkzeug für kreative Bearbeitung.

7. Praxisbeispiele

- Nano‑Banana in Hugging Face: Integration mit Qwen‑Image‑Edit, Prompt‑Enhancer und LoRA‑Feintuning für ultraschnelle 8‑Step-Generierung.

- Bylo.ai-Features: Stiltransfer, Objekt-Swap, 2D‑zu‑3D-Konvertierung, fotorealistische Porträt-Optimierung.

- LMArena: Vergleichstests gegen andere Top-Modelle, bei denen Nano‑Banana oft als „präziser Editor“ hervorsticht.

8. Bedeutung für Künstler und Kreative

Nano‑Banana könnte sich als besonders wertvolles Tool für jene herausstellen, die kontrollierte Bildbearbeitung suchen – also Fotografen, Designer und Illustratoren, die weniger „Zufall“ und mehr präzise Umsetzung wollen. Die Kombination aus:

- präzisem Prompt-Verständnis,

- stilistischer Kohärenz,

- schneller Generierung

… macht es zu einem potenziellen Game Changer.

Fazit

Nano‑Banana ist mehr als nur ein weiterer Name in der Flut neuer KI-Modelle. Es ist ein Geheimtipp mit großem Zukunftspotenzial. Noch bleibt vieles im Dunkeln: Wer steckt dahinter? Wann wird es öffentlich freigegeben? Und welche Lizenzmodelle werden gelten?

Doch klar ist schon jetzt: Nano‑Banana beweist, dass die nächste Entwicklungsstufe von Bild-KI nicht unbedingt in reiner Power liegt – sondern in Präzision, Konsistenz und smarter Integration in kreative Workflows.

Weiterführende Links

- Flux AI – Nano‑Banana

- Bylo.ai – Nano‑Banana Features

- Hugging Face – Open Nano‑Banana

- Reddit Diskussionen zu Nano‑Banana

- Flux Blog – Hintergründe zu Nano‑Banana