B-R-O-W-N-Z Blog: Bildersuche mit KI – Schluss mit dem Palm-Problem!

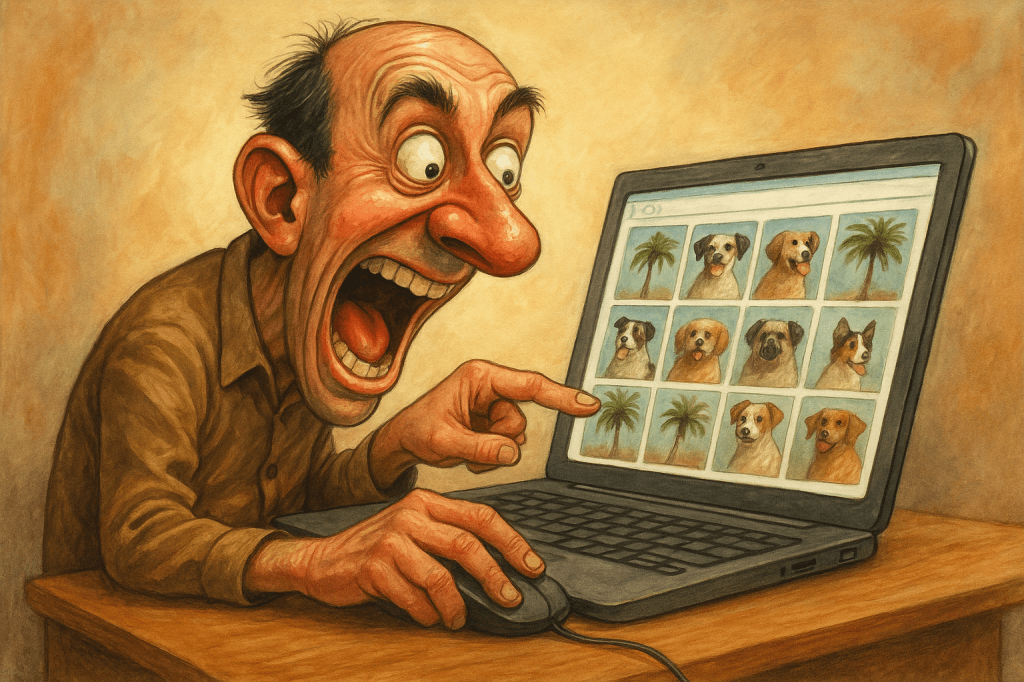

Du sitzt auf Terrabyte an alten Fotos, willst „Hund am Strand“ finden – und bekommst Palmen. Warum? Weil irgendjemand mal „palm“ mit „Handfläche“ gleichgesetzt hat, und zack, ist dein Hund verloren im digitalen Dschungel. Willkommen in der Welt der Schlagwortsuche. Willkommen in der Vorhölle.

Aber keine Panik, mein visuell geplagtes Wesen. Ich erklär dir, wie die semantische Suche mit KI das Bilderchaos entmüllt – und warum du künftig lieber mit Vektoren als mit Worten arbeitest. Und natürlich, wie und wo du das selbst einsetzen kannst – ganz praktisch, ganz konkret.

1. Klassisch nervig: Die Schlagwortsuche

Früher hieß Bildverwaltung: „Ich tagge mal alles schön mit Keywords“ – also genau das, was du nie tust. Weil’s fad ist. Weil du im Zweifel eh nicht mehr weißt, ob das Bild unter „Sonnenuntergang“, „Romantik“ oder „Urlaub Fail“ lief. Und weil du spätestens nach 200 Bildern beginnst, aus Trotz Emojis als Tags zu verwenden.

Und selbst wenn du’s durchziehst: Die Schlagwörter sind wild. Mal auf Deutsch, mal auf Englisch, mal schreibt wer „Katze“, mal „Flauschmonster“. Im besten Fall findest du Palmen. Im schlimmsten: nichts.

2. KI sagt: „Zeig mir, was du meinst“

Hier kommt die semantische Suche ins Spiel. Statt deine Datenbank mit Tags vollzukleistern, lässt du die KI für dich denken. Sie analysiert Bilder – und zwar nicht nach dem Motto „ist rot, ist rund, ist Apfel“, sondern sie packt jedes Bild als sogenannten Vektor in einen Merkmalsraum.

Hä?

Stell dir den Merkmalsraum wie ein riesiges unsichtbares Universum vor, in dem jedes Bild als Punkt irgendwo rumschwebt. Je ähnlicher zwei Bilder sind, desto näher liegen sie. Hundebilder ballen sich wie ein Rudel zusammen, Regenbilder duschen nebeneinander.

Und: Auch Text landet in diesem Raum! Schreibst du also „ein französischer Mops mit Schleife, der melancholisch auf einen Eiffelturm schaut“, sucht die KI automatisch nach Vektoren, die genau so ticken.

3. Wie funktioniert das technisch?

Das Ganze basiert auf neuronalen Netzen (ja, diese Blackbox-Wunderwerke), konkret oft auf dem CLIP-Modell von OpenAI. CLIP bringt Bild und Text in denselben Merkmalsraum. Und nein – du musst keine Ahnung haben, was „Dimension“ genau bedeutet, nur so viel:

- Jedes Bild = Vektor mit Hunderten bis Tausenden Merkmalen

- Jeder Text = Vektor mit ebenso vielen Koordinaten

- KI vergleicht diese Vektoren und sagt: „Aha, passt!“

Das Ganze ist wie Tinder, nur für Bilder und Worte. Und weniger peinlich.

4. Text oder Bild – du hast die Wahl

Du kannst der KI sagen:

- „Zeig mir Bilder wie dieses da!“ (visuelle Suche)

- „Ich suche ein Kind in rotem Regenmantel auf einem verregneten Bahnsteig“ (textbasiert)

- Oder du kombinierst beide Methoden. Hardcore!

Profi-Tipp: Wenn du mehrere Bilder als Beispiel gibst, sucht die KI in der Mitte des „Vektor-Durchschnitts“. Ideal, wenn du eine Serie meinst, aber nicht das eine perfekte Bild findest.

5. Und wie geht das schnell?

Der Merkmalsraum ist riesig. Also nutzt man sogenannte Vektordatenbanken wie Pinecone oder Milvus. Die funktionieren wie ein Navi im Hyperraum: Sie wissen, wo was liegt, ohne jedes Mal ganz Google Earth zu simulieren.

Diese Datenbanken sind speziell auf schnelle Annäherung getrimmt (Stichwort: ANN – Approximate Nearest Neighbor). Für uns heißt das: Blitzschnelle Suche ohne Bruchlandung.

Auch Open-Source-Tools wie FAISS (von Facebook), Weaviate oder Qdrant können solche Vektorsuchen lokal auf dem eigenen Rechner oder Server ermöglichen. Es gibt sogar fertige Dienste wie img2dataset oder ClipReclip, mit denen du eigene Bilddatenbanken automatisch analysieren lassen kannst – ohne dass du selbst Deep Learning studieren musst.

6. Warum das Ganze? Was bringt’s dir wirklich?

Weil du keine Lust mehr hast, 45 Minuten lang durch kryptisch benannte Ordner wie „Final-Final-Endgültig-Version2-Bearbeitet-Kopie“ zu klicken. Weil du nach dem Shooting weißt, was du gemacht hast – aber drei Wochen später nur noch „da war irgendwas mit Regen und einem Pferd“ im Kopf hast. Und weil deine kreative Arbeit zu wertvoll ist, um als Datenmüll zu enden.

Hier ein paar echte, praktische Gründe, warum du die semantische Bildersuche lieben wirst:

- Zeitsparend bis zum Anschlag: Statt 2000 Thumbnails durchzuscrollen, suchst du mit einem Satz. Und findest das passende Bild in Sekunden.

- Sprachlich flexibel: Deutsch, Englisch, Französisch, Dialekt? Die semantische Suche ist polyglott. Du kannst sogar vage suchen: „Frau schaut nachdenklich aus dem Fenster“ funktioniert besser als jedes Keyword.

- Visuelle Denker willkommen: Wenn dir Worte fehlen, nutzt du ein Referenzbild. Oder fünf. Die KI erkennt den gemeinsamen Stil und Inhalt – auch bei variierender Perspektive, Farbstimmung oder Auflösung.

- Unabhängig von deiner früheren Ordnerstruktur: Du kannst auch dann suchen, wenn du selbst keine Ahnung hast, wie das Bild abgespeichert wurde. Die KI findet’s trotzdem.

- Kuratierung leicht gemacht: Serien, Looks, wiederkehrende Motive – all das erkennt die KI automatisch. Ideal für alle, die mit Moodboards, Portfolios oder Kundenpräsentationen arbeiten.

- Funktioniert auch bei Sound und Video: Spotify nutzt die gleiche Technik, um dir ähnliche Songs vorzuschlagen. Nur dass du jetzt dein Bildarchiv rockst.

7. Wo wird semantische Suche heute schon eingesetzt?

- Stock-Agenturen: Anbieter wie Shutterstock, Adobe Stock und Getty nutzen semantische Suche längst – oft sogar mit deinem Freitext. Such dort einfach mal nach „sad robot in a sunflower field“.

- Fotomanagement-Software: Tools wie Eagle, Pixy oder Fotostation setzen erste KI-Module ein. In Lightroom und Bridge kommt man per Plug-in oder Umweg über externe Tools (z. B. Imagga oder Pimeyes) ans Ziel.

- Eigene Datenbankprojekte: Wenn du nerdy drauf bist, kannst du CLIP mit Python und FAISS auf deine eigene Bildsammlung loslassen. Oder du nutzt das Webtool clip-retrieval (https://github.com/rom1504/clip-retrieval) als ready-to-go-Server.

- CMS-Systeme und DAMs: Große Unternehmen integrieren solche Suche direkt in Digital Asset Management-Systeme – z. B. bei Verlagen, Museen, Online-Shops oder Architekturbüros.

8. Mein Fazit:

Semantische Bildersuche ist das beste, was deinem kreativen Chaos je passieren konnte. Kein Geklicke mehr durch Jahrgänge. Kein Verzweifeln an „war das 2020 oder 2021?“. Kein „wie hab ich das jemals benannt?!“.

Stattdessen: Denk, beschreib, find. Mit Stil. Mit KI. Mit BROWNZ.

Willst du wissen, wie du das in Lightroom, Photoshop oder deinen eigenen Systemen nutzen kannst? Schreib mir – oder komm in die BroBros-KI-Kommandozentrale.

Entdecke mehr von Der BROWNZ Blog

Melde dich für ein Abonnement an, um die neuesten Beiträge per E-Mail zu erhalten.